帮朋友小胖“去”德国封装AI大模型镜像

楔子

- 烦 又是小胖(上回说到小胖学python从入门到放弃,干脆这回主角也叫小胖,不是上次那个小胖,反正都胖)。前天晚上小胖给我打电话,说他们公司也要部署deepseek大模型。问我这好弄不?我倒是回答,这东西挺简单。请我吃烧烤,我就帮你弄!还问他要8b,32b大模型?小胖都不知道8b,32b是什么!啊!还是先把烧烤吃了再说。

前奏

烧烤 终于坐到饭桌上了,这是重要的的一步开始。先把东西吃了,再说,然后再想如何帮小胖部署大模型,不就三句话的事情么!终于等到小胖了,一顿酒桌寒暄与拉家常下(其实嘴也没停下来)。终于进入正题了。其实,也不算他们公司想部署大模型,他们上层公司倒是有这个意思,但是目前没精力弄。目前,就是他们部门先弄一个出来看看,看看能不能解决他们的业务需要(其实理论上可以的)。然后掏出一顿话术,给他解释了,8b模型笨,32b模型聪明点,满血600B模型他们肯定是玩不起云云。还有他们的工作流配置问题,需要用一个叫Dify的工具等等。

纠结 结果他一听32b大模型可能要烧掉他20GB显存(也就是需要大概4090显卡才能带动,大概价格1万)。小胖说他们公司都是穷逼,电脑都没显卡。现在这个接骨点,又没看到效果,申请不到经费的。他只能把自己的老AMD显卡贡献出来(啊!这儿要单独适配驱动,又增加活)。然后问能不能先跑一个8b.当然酒足饭饱后只能答应了。

部署

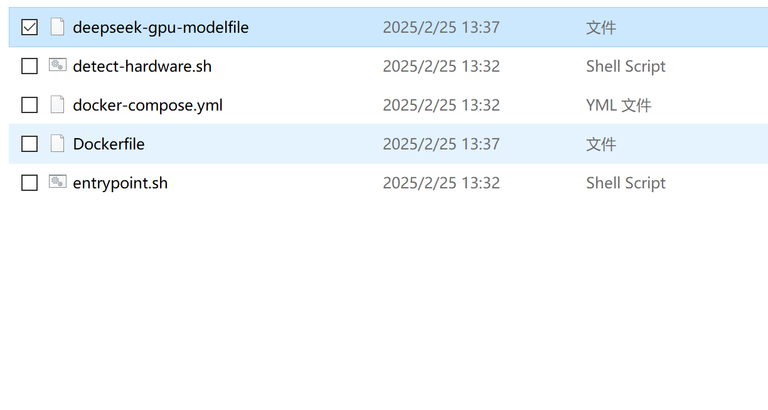

pull 第二天,头痛脑热的醒来。一看还要给小胖配置大模型呢。到底怎么办呢?按照他的需求其实就是ollama+deepseek-r1:8b+Dify总体来说其实也简单。就是几个pull命令事情(关键Dify没有镜像,网络又不通)。直接去小胖公司部署,又耽误时间,而且小胖还没有把他显卡拿过去。先把上面的这些工具与大模型,调调通用适配,然封装成一个docker镜像。把镜像发给小胖,小胖一键部署就行了。

理想 理想是丰满的现实是残酷的,打开的我的远程实例(电脑)把所有东西,一个两个小时过去了,都安装好了,突然发现我的实例没有权限构建docker镜像(因为本身就是一个docker).现在轮到我头大了。最后只能托朋友看看谁有空闲服务器借我用用。最后终于找到一个德国服务器,最终把小胖要的镜像打包好了!妈耶!都晚上12点了。把链接给了小胖让他自己下载。结果速度就是只有十几KB(总笔github他下载不了,好)。等他自己下载四天。

END

- 肚子 终于算是把小胖破事给弄完了!这个故事告诉我们一个什么道理,不要乱吃东西。就因为吃了烧烤,我肚子痛了一天,现在还在痛呢。

Posted Using INLEO

烧烤可能有“料”

不好说

你嘴馋了入坑!祝你下次会运气好不会吃坏肚子

@tipu curate

Upvoted 👌 (Mana: 43/63) Liquid rewards.

哈哈哈

哈哈哈!通常我只叫可爱小狗狗小胖。

哈哈哈,反正就是胖